L’analyse de données textuelles informatisée

Avant le 30 novembre - revue {Nouvelles perspectives en sciences sociales}

Pour un prochain numéro de la revue Nouvelles perspectives en sciences sociales, Revue internationale de systémique complexe et d’études relationnelles

"Nous aimerions beaucoup que ce numéro compte parmi ses collaborateurs des chercheur(e)s en études de genre qui on réfléchi sur le thème de ce numéro ou qui font usage de ces outils informatisés dans l’exercice de leur métier."

Argumentaire :

Un débat ancien et récurrent oppose les sciences humaines et sociales (SHS), dites « molles » de façon généralement péjorative, aux sciences de la nature, dites a contrario « exactes » ou « dures », de façon abusive. Sans entrer dans ce débat et ses multiples facettes, on peut au moins avancer que si les SHS, en effet, ne sont pas des « sciences expérimentales », elles sont cependant des « sciences empiriques », dans le sens où elles sont en mesure de produire des études sur des faits observables. Comme les sciences de la nature, d’ailleurs, elles doivent construire leur objet et reconnaître aussi bien leur dimension historique et contingente que leur aptitude à produire quelques généralisations.

Pour n’évoquer ici que les sciences sociales, l’une des difficultés est « de bannir tout jugement de valeur, pour ne rechercher que les régularités et/ou des propositions vérifiables par l’expérimentation et les tests empiriques ».

Les analyses de données textuelles occupent depuis fort longtemps une place de choix dans la recherche empirique dans les SHS. Discours politiques, paroles d’acteurs de la société, relations de faits par les médias... offrent un riche corpus permettant de se faire une idée sur tel ou tel aspect de la vie sociale et de l’interpréter à l’aune des théories disponibles ou créées pour ce faire.

Le risque, cependant, est que l’herméneutique ainsi mise en œuvre ne soit traversée d’une trop forte tendance émotive : Gaston Bachelard condamnait la « connaissance première ou ordinaire » qu’il jugeait être un obstacle à la connaissance rationnelle. Sur des corpus analysables par un seul cerveau, voire une équipe de cerveaux, donc fortement limités aux capacités cognitives des humains, les régularités dont parle Robert Boyer peuvent être liées à des échantillons trop étriqués et la connaissance rationnelle peut se heurter à cette insuffisance. On risque donc de palier cette insuffisante en se livrant à des déductions qui, sous couvert de scientificité, peuvent n’être que le fruit d’un leurre créé par une raison insuffisamment étayée et capable de déborder de toutes parts les limites de la méthode, quelle que soit cette dernière.

L’apparition des analyses de données textuelles informatisées, vers les années 1960-70, puis leur développement à partir de la fin des années 1990, a permis de fournir aux chercheurs des outils de désubjectivation des travaux sur la société. L’importance quantitative des corpus susceptibles d’être traités par l’outil informatique et la rapidité de ce traitement donnent des chances notables de ne pas se laisser aller à des corrélations illusoires, à des régularités mensongères : elles facilitent la « capacité propre à la discussion paramétrique [...] d’établir en toute clarté les conditions de validité d’un résultat donné ».

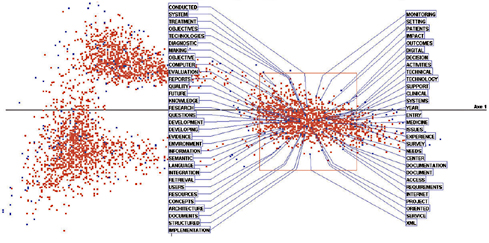

Cet outil permet de multiplier les angles de vue, d’adapter les analyses aux besoins et désirs du chercheur : diversité des points de vue (problématiques, hypothèses), des approches (construction de catégories multiples), des représentations résultantes (tableaux, graphiques, treillis...) ou encore des types d’opérations possibles : analyses d’entretiens directifs ou semi- directifs, de réponses à des questions ouvertes, d’extraits de presse, de textes littéraires, d’interactions en face-à-face, de discussions de groupe...

Bien entendu, la puissance de l’instrument informatique ne donne pas en elle-même une garantie de scientificité des analyses. Elle ne prémunit pas contre les erreurs d’interprétation, les glissements idéologiques. Elle ne dispose pas a priori de bases solides et indiscutables.

Les logiciels de traitement de données textuelles sont construits sur des hypothèses qui ne sont pas neutres sur les résultats produits. Le codage des données, la diversité des techniques d’analyses (modes de création des unités textométriques de base, par exemple), le champ de validité de l’outil, tout cela doit être connu et assumé au cours de la recherche. En outre, l’outil reste un instrument au service du chercheur. C’est ce dernier qui pilote l’étude et, en connaissance de cause (c’est-à-dire des éléments qui précèdent), doit effectuer les choix à la fois de ce qu’il examine, de ce qu’il recherche et de ce qu’il interprète...

Malgré un développement concret s’étalant sur une quinzaine d’années, on peut juger à bon droit que les logiciels d’analyse de données textuelles sont encore relativement trop peu utilisés par les chercheurs en SHS. À la peur de l’outil (et de l’investissement cognitif et en temps, supposé et en partie réel), s’ajoutent sans doute les préventions fondées sur les dangers anticipés de l’instrument : les qualitativistes le trouvent sans doute trop rationalisant, les quantitativistes, sans doute pas assez...

La revue NPSS a souhaité permettre à ses lecteurs de se pencher sur ces nouveaux outils pour en comprendre les possibilités et les risques, les modes possibles d’utilisation et les précautions à observer, les types de logiciels, leurs objectifs respectifs et leurs différences...

Les contributions pourront porter (de façon non limitative) sur les axes suivants : ![]() Les avantages ou les désavantages que peut apporter aux chercheurs en SHS l’utilisation des logiciels d’analyse de données textuelles ;

Les avantages ou les désavantages que peut apporter aux chercheurs en SHS l’utilisation des logiciels d’analyse de données textuelles ; ![]() La fiabilité des logiciels d’analyse de données textuelles ;

La fiabilité des logiciels d’analyse de données textuelles ; ![]() La désubjectivation des analyses lexicales ;

La désubjectivation des analyses lexicales ; ![]() Le positionnement entre qualitatif et quantitatif que suppose l’analyse informatisée de données textuelles ;

Le positionnement entre qualitatif et quantitatif que suppose l’analyse informatisée de données textuelles ; ![]() La comparaison entre les divers logiciels d’analyse de données textuelles ;

La comparaison entre les divers logiciels d’analyse de données textuelles ; ![]() Des exemples d’application des analyses textuelles informatisées...

Des exemples d’application des analyses textuelles informatisées...

Calendrier :

Les auteurs intéressés par cette problématique annonceront avant le 30 novembre leur projet à Simon Laflamme (slaflamme@laurentienne.ca) et à Claude Vautier (claude.vautier@ut- capitole.fr). Les articles seront expédiés à la même adresse au plus tard le mardi 31 mars 2015. Ceux qui traverseront avec succès le processus d’évaluation seront publiés dans le volume 11, numéro 1 de la revue en novembre 2015. Ils auront respecté les prescriptions figurant dans le guide des auteur(e)s sur le site de la revue (http://npssrevue.ca/contributions).

Fichiers de syndication :

Statistiques :

Le site contient 4383 articles